Rechnen fürs Klima (Teil 2): Wie moderne Klimamodelle funktionieren

In unserem letzten Beitrag schlugen wir einen Bogen von den theoretischen Anfängen der Wetterberechnung zur modernen Klimamodellierung auf massiv-parallelen Computersystemen. Dieser Folgeartikel dreht sich um Klimamodelle und die grundlegende Frage: Wie können wir die sich laufend verändernde Atmosphäre simulieren?

Computersimulationen ermöglichen die tägliche Wettervorhersage und sind enorm wichtig, wenn es darum geht, den Herausforderungen des Klimawandels zu begegnen. Um das Verhalten des Klimasystems verstehen und vorhersagen zu können, konstruieren und nutzen Wissenschaftler komplexe Rechenmodelle, welche die relevanten chemischen und physikalischen Eigenschaften der Erdoberfläche (Land und Ozeane) in vereinfachter Form berücksichtigen. Aber wie funktionieren Klimamodelle genau, und welche Implikationen für die Informatik bringen sie mit sich?

Rechnen auf dreidimensionalen Gittern

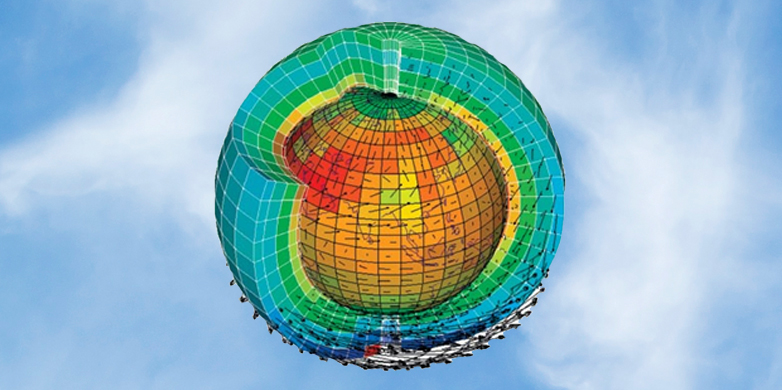

Ähnlich den frühen Bemühungen von Richardson (siehe Teil 1 dieses Zweiteilers) spannen moderne Klimamodelle ein dreidimensionales Rechengitter über die Erde. Das erlaubt es, die physikalischen Gesetze zu berechnen, welche die Atmosphäre beeinflussen: In jeder Gitterzelle gibt es Werte für Windgeschwindigkeit, Temperatur, Druck, relative Luftfeuchtigkeit und Konzentrationen atmosphärischer Bestandteile (insbesondere Wasserdampf, aber auch andere Gase und Aerosole), die zusammen den aktuellen Zustand der Atmosphäre in diesem Bereich definieren. Je kleiner die Gitterzelle, desto höher ist die Auflösung des Modells. Unter Berücksichtigung der physikalischen Gesetze berechnet ein Computerprogramm dann Schritt für Schritt alle Werte für zukünftige atmosphärische Zustände. Um die Werte in einer bestimmten Zelle zu aktualisieren, benötigt die Software auch Informationen aus den benachbarten Zellen. Solche Programme werden oft als Stencilprogramme bezeichnet [1]. Da die Berechnungszeit und der Speicherbedarf linear mit der Anzahl Gitterzellen wachsen, ist die effiziente parallele Implementierungen von Stencilprogrammen ein wichtiges Forschungsthema des Scalable Parallel Computing Laboratory SPCL. Unter den folgenden Referenzen findet sich eine Einführung zu Klimamodellen sowie eine Tornado-Simulation: [2], [3].

Millionen von Prozessoren auf Trab halten

Wenn wir einen Klima- und Wettercode auf einer hochskalierenden Maschine wie dem Piz Daint am Centro Svizzero di Calcolo Scientifico externe Seite CSCS implementieren, müssen wir das Stencilprogramm so parallelisieren, dass es auf Millionen von Verarbeitungselementen ausgeführt werden kann. In Zusammenarbeit mit MeteoSchweiz und dem CSCS hat ein Student am SPCL, Tobias Gysi, eine spezialisierte Programmiersprache entwickelt, die es Meteorologen erlaubt, Stencilprogramme sehr einfach anzupassen, und es Informatikern gleichzeitig ermöglicht, die Ausführung der Programme zu parallelisieren und zu optimieren. Diese domänenspezifische Sprache (DSL, «domain-specific language») trennt so die Arbeit des Meteorologen, der das eigentliche wissenschaftliche Rechenproblem definiert, von jener des Informatikers, der die auszuführende Berechnung optimiert. Solche domänenspezifische Sprachen effizient und automatisch für heterogene Hardware zu optimieren stellt eine wichtige Forschungsaufgabe für die Informatik dar.

Eine weiteres Forschungsgebiet ist das Speichern und Verwalten der gewaltigen Datenmengen, die schon während einer einzigen Simulation anfallen. Parameter wie Druck und Windgeschwindigkeit werden für jeden Gitterpunkt und jeden Zeitschritt gespeichert. Man geht davon aus, dass das Datenvolumen in naher Zukunft Exabytes erreichen könnte (1018 Bytes, das entspricht 1’000’000 1-TB-Festplatten). Dafür sind neue leistungsstarke Techniken für die Datenerzeugung und -verwaltung sowie für Online-Analysen nötig. Diese Herausforderungen gehen MeteoSchweiz, das CSCS und die ETH Zürich in einer Kollaboration an, die der Schweizerische Nationalfonds im Rahmen des Programms Sinergia finanziert. [4]

Den Klimawandel über den Alpen und Europa modellieren

Kürzlich wurde eine umfangreiche Simulation des europäischen Sommers fertiggestellt [5], [4]. Sie verwendet ein Rechennetz von 500 x 500 x 60 Gitterpunkten bei einer horizontalen Auflösung von 2,2 km und deckt einen Zeitraum von 30 Jahren ab. Um die damit verbundenen enormen Datenmengen effizient zu verwalten, wurde nur ein kleiner Teil der Ausgabe gespeichert. Dennoch umfasst das Archiv mehr als 120 TB. Die Simulation erfolgte mit einer konventionellen Version des COSMO-Modells und konsumierte über eineinhalb Jahre Rechenzeit auf dem Supercomputer Monte Rosa am CSCS.

Als nächstes wollen wir ähnliche Simulationen mit der GPU-fähigen Version von COSMO durchführen; diesmal aber soll die Modellierung den gesamten europäischen Kontinent mit einem zehnmal grösseren Rechengebiet abdecken (siehe Abbildung und Animation in Teil 1). Dabei soll auch eine neuere Hardware-Architektur zum Einsatz kommen (Cray XC30, Piz Daint) [3]. Piz Daint weist eine beachtliche Spitzenleistung von 6 x 1015 Flop/s (Gleitkommaoperationen pro Sekunde, «floating point operations per second») auf und verfügt über insgesamt 5‘272 Rechenknoten. Da unsere aktuelle Implementierung der COSMO-GPU-Version nur 144 Knoten benötigt (das heisst drei Prozent), ist die geplante Ausdehnung des Rechengebietes ein sehr realistisches Ziel.

Mit diesen Berechnungen möchten wir den Wasserzyklus einschliesslich extremer Starkniederschlagsereignisse besser verstehen und vorhersagen. Simulationen im alpinen Raum haben bereits interessante Ergebnisse zu Tage gebracht, die kaum glaubhaft wären, wenn sie auf semi-empirischen Annahmen basieren würden. Die Resultate deuten nämlich darauf hin, dass die durchschnittliche Sommerniederschlagsmenge bis Ende des Jahrhunderts um rund 30 Prozent sinken wird, während die Häufigkeit heftiger Gewitter und Regenschauer erheblich ansteigen wird. Anders gesagt geht man davon aus, dass Extremfälle an beiden Enden des Spektrums, also sowohl Dürren wie auch Sturzfluten, zunehmen werden. Erkenntnisse aus solchen Experimenten können für die Anpassung an den Klimawandel interessant sein: Denn kurzfristige Starkniederschlagsereignisse haben Konsequenzen für die Art und Weise, wie wir Wasservorräte verwalten und uns vor Hochwasser schützen sollten.

Kooperation fördert Klimawissenschaften

Für die Vorhersage des Wetters und des Klimas sind nicht nur leistungsfähige Computer nötig, es bedarf auch einer engen Zusammenarbeit zwischen den Klimawissenschaften und der Informatik. Heterogene Hardware-Architekturen sind unerlässlich für moderne Simulationen, sie erfordern aber einen grundlegend neuen Ansatz in der Softwareentwicklung. Die aktuelle Version des COSMO-Modells ist das weltweit einzige verfügbare regionale Wetter- und Klimamodell, das vollständig auf GPUs laufen kann. Dieser Fortschritt und die daraus entstandenen Perspektiven sind die Früchte einer engen interdisziplinäre Zusammenarbeit zwischen dem CSCS, MeteoSchweiz, dem C2SM und der Departemente Informatik und Umweltsystemwissenschaften der ETH Zürich.

Torsten Hoefler hat diesen Blogbeitrag zusammen mit Christoph Schär (ETH Zürich) und Oliver Fuhrer (MeteoSchweiz) geschrieben.

Weiterführende Informationen

[1] externe Seite Stencil code

[2] An introduction to externe Seite climate models

[3] Tornado externe Seite simulation

[4] crCLIM: Convection-resolving climate modeling on future supercomputing platforms. A Sinergia project funded by the SNF.

[5] Ban N., J. Schmidli and C. Schär, 2015: Heavy precipitation in a changing climate: Does short-term summer precipitation increase faster? Geophys. Res. Lett., 42 (4), 1165–1172 externe Seite doi.

[6] Fuhrer, O., C. Osuna, X. Lapillonne, T. Gysi, B. Cumming, M. Bianco, A. Arteaga and T. C. Schulthess, 2014. Towards a performance portable, architecture agnostic implementation strategy for weather and climate models. Supercomputing Frontiers and Innovations, 1 (1), 45-62

Kommentare

Wie sind Klimamodelle zu bewerten, die die Vergangenheit nicht reproduzieren können und trotzdem für Zukunftsmodellierungen eingesetzt werden? In der Modellierungswelt gilt eigentlich, dass sich Modelle zunächst im "Hindcast" bzw. "History Match" bewähren, bevor sie für Prognosen freigeschaltet werden können. Nun hat aber der IPCC in seinem letzten Bericht in Kapitel 5.3.5 (Arbeitsgruppe 1) ganz klar festgestellt, dass die verwendetetn Modelle den Wärmeausschlag der Mittelalterlichen Wärmperiode nicht reproduzieren können. Wie ist dieses Dilemma zu lösen? Würde es sich um ein Fluzeug handeln, blieben alle Flieger bis zur endgültigen Klärung am Boden.

Eine Frage, die ich schon zum Beitrag "Prognosen" schrieb, hier nochmal wiederholt: sind die Klimamodellle validiert, d.h. konnten Sie die nahe Vergangenheit auf Basis der Daten der ferneren Vergangenheit abbilden? Ich habe gehört oder gelesen, dass das bisher nicht gelungen sei. Wenn dem tatsächlich so ist, dann sind diese Modelle noch lange nicht ausgereift und sind nur "wissenschaftliche Spielereien" - sind sie aber validiert, sollte das Vertrauen in ihre Ergebnisse als sehr hoch angesehen werden.

Die laufende Überprüfung und Verbesserung von Klimamodellen anhand des vergangenen Klimas ist in der Tat sehr wichtig und trägt viel zur Verbesserung von Klimamodellen bei. Globale Modelle werden anhand der längerfristigen Klimaentwicklung validiert. Sie sind in der Lage, die grossräumige Erwärmung der letzten 100 Jahre adäquat zu simulieren (siehe z.B. http://www.ipcc.ch/pdf/assessment-report/ar5/wg1/WG1AR5_SPM_FINAL.pdfcall_made, Fig. SPM.6). Das im Blog beschriebene regionale Modell wurde überprüft indem ein zehnjähriger Zeitraum (1998-2007) über den Alpen simuliert wurde. Die Simulationen sind in der Lage, das regionale Niederschlagsklima überzeugend darzustellen, inklusive Starkniederschläge (Ban et al. 2014, http://onlinelibrary.wiley.com/doi/10.1002/2014JD021478/abstractcall_made ).

Sorry Herr Leutwyler, ich fragte nicht nach der Evaluierung, sondern nach der Validierung. Zwischen beiden Methoden besteht ein "himmelweiter" Unterschied. Nach Ihrer Aussage und dem, was ich im letzten IPCC-Sachstandsbericht (dem kompletten, nicht der von Politikern redigierten Kurzfassung) entnahm, ist es dann wohl tatsächlich noch nicht gelungen mit den Klimamodellen das Klimageschehen, das schon stattfand, nachzubilden. Tja, dann stehen doch logischerweise die ganzen Klimaprophezeiungen auf mehr als nur wackligen Beinen - sie funktionieren dann noch gar nicht. Dann sollte man doch mit den "Vorhersagen" ganz ganz leise sein statt so alarmistisch, wie seit Jahren und zur Zeit wieder vor der Pariser Klimakonferenz.

Guten Tag Herr Richter Die Evaluation von Klimamodellen mit vergangenem Klima ist ein verbreitetes Standardverfahren. Die folgende Studie vergleicht z. B. mehrere regionale Klimamodelle sowohl untereinander aber auch mit Messdaten: Kotlarski et al. (2014): Regional climate modelling on European scales: A joint standard evaluation of the EURO-CORDEX RCM ensemble. Geoscientific Model Development, 7, 1297-1333. Eine Evaluation der in Artikel erwähnten Simulation des Klimas im Alpenraum finden Sie hier: Ban et al. (2014), Evaluation of the convection-resolving regional climate modeling approach in decade-long simulations, J. Geophys. Res. Atmos., 119, 7889–7907, doi:10.1002/2014JD021478call_made.

Ich möchte mich dem Kompliment von Roman Klingler anschliessen: Gut erklärt und mit interessanten Einblicken. Eine eigene benutzerfreundliche Sprache für die Wetter- und Klimamodellierung zu schaffen scheint mir eine sehr gute Idee. Sie passt auch zu einem Grundgedanken in der Entwicklung von informatischen Abstraktionen: "Separation of concerns". Die Informatiker sollen tun was sie am besten können und die Meteorologen ebenso. Die Kunst besteht darin, die "richtige" Separierung vorzunehmen, so dass beide Seiten gute Resultate lieferen können ohne sich ständig miteinander absprechen zu müssen.

Kompliment für die beiden spannend und gut geschriebenen Beiträge zum Funktionieren von Klimamodellen.

Europas Oberfläche und Atmosphäre zur Simulation europäischer Sommer mit 500 x 500 x 60 Gitterpunkten (bei einer horizontalen Auflösung von 2,2 km) zu erfassen und auf jeder dieser Gitterzellen (15 Millionen Gitterzellen) einen grossen Satz von physikalischen Gleichungen anzuwenden, das ist wirklich beeindruckend. Ich hoffe doch, dass man damit nicht nur zukünftige Sommer durchrechnet, sondern auch vergangene Sommer. Und dass man die nötigen Daten für die vergangenen Sommer überhaupt hat und also die (historische) Realität mit dem Modell vergleichen kann. Schöne Modelle sind gute Modelle. Und gute Modelle sind Modelle, die die Realität gut wiedergeben.