Weshalb wir neue Klimamodelle brauchen

Klimamodelle sind eine Erfolgsgeschichte, viele ihrer Voraussagen sind eingetroffen. Weshalb die Forschung dennoch neue Modelle braucht, erklärt Reto Knutti in seinem Blogbeitrag.

Als 1950 die Meteorologen Jule Charney, Ragnar Fjørtoft und der Mathematiker John von Neumann zusammen mit anderen Forschenden erstmals am Computer das Wetter simulierten, brauchten sie 24 Stunden Rechenzeit, um eine Prognose für 24 Stunden Wetter zu erstellen. Die Voraussage war dürftig, die Realität war schon eingetroffen und damit die Voraussage für niemanden brauchbar. Heute ist die Wetterprognose erstaunlich gut, oft bis eine Woche im Voraus und für extreme Ereignisse. Sie ist auf jedem Telefon verfügbar, und alle wissen, wie sie zu interpretieren ist.

Erstaunliche Entwicklung der Klimamodelle

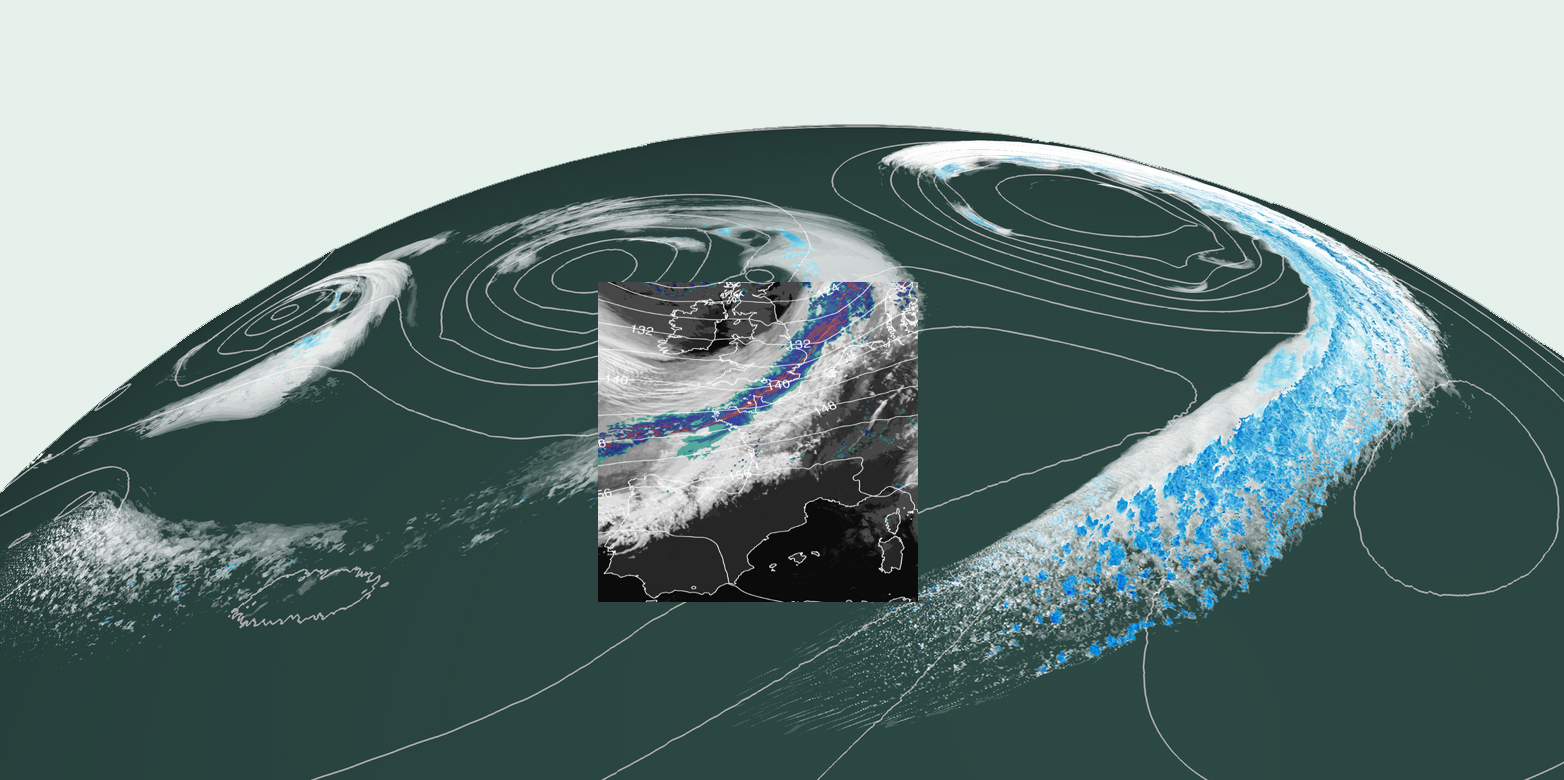

Auch die eng mit Wettermodellen verwandten Klimamodelle haben eine erstaunliche Entwicklung durchlaufen. Sie simulieren heute die Strömungen in der Atmosphäre und im Ozean, das Meereis, die Biosphäre und das Land, den Kohlenstoffkreislauf und vieles mehr. Klimamodelle berücksichtigen Tausende von Rückkopplungen und Prozesse des Klimas, umfassen eine Million Zeilen Programmcode, produzieren Petabytes von Daten – und die Modelle sind eine Erfolgsgeschichte. Viele der Voraussagen der Klimamodelle sind eingetroffen1,2. Aufgrund solcher Voraussagen hat die internationale Klimapolitik entschieden, dass wir die menschgemachte Erwärmung auf deutlich unter 2 Grad begrenzen wollen. Aber warum braucht es denn diesbezüglich noch mehr Forschung und neue Modelle?

«Alle Modelle sind falsch, aber einige sind nützlich», sagte der Statistiker George Box schon vor Jahrzehnten. In der Tat vereinfacht jedes Modell die Realität. Für gewisse Fragen ist es genau genug, für andere sind die Unsicherheiten noch hoch. Insbesondere hat jedes Modell eine bestimmte räumliche Auflösung oder Gitterweite. Darunter sind keine Aussagen möglich. Bei den Klimamodellen liegt die Gitterweite heute typischerweise bei 10 bis 50 km. Dass wir CO2 reduzieren müssen, ist auch mit dieser Auflösung klar. Geht es aber darum, wie häufig heisse und gleichzeitig trockene Sommer wie 2018 auftreten, oder ob es im bündnerischen Sedrun im Jahr 2040 noch genügend Schnee hat, benötigen wir eine Gitterweite von wenigen Kilometern. Weil Berge und Täler, aber auch lokale Prozesse wie zum Beispiel das Aufsteigen von Luftmassen, das zu Wolkentürmen führt, entscheidend werden.

«Die schönste Simulation ist nutzlos, wenn Nutzerinnen und Nutzer sie nicht verstehen, oder nicht wissen, was sie damit anfangen sollen.»Reto Knutti

Doch um die Gitterweite verkleinern zu können, braucht es eine enorme Rechenleistung, über die immer häufiger nur Rechner mit Grafikprozessoren (GPU) verfügen. Dazu müssen aber die «Innereien» des Modells, also wie die einzelnen Rechenkerne Daten austauschen und verarbeiten, neu programmiert werden. Mit solchen leistungsfähigen Grossrechnern können kleinräumige Prozesse wie Gewitterwolken oder Stadtmodelle anders und besser abgebildet werden. Dabei werden aber so viele Daten produziert, dass man gar nicht mehr alle speichern kann.

Bis ein hochaufgelöstes Modell auf einer neuen Rechnerarchitektur läuft, braucht es also die Expertise von Physikern, Chemikern, Biologen und weiterer Fachleute, um die kleinräumigen Prozesse besser zu beschreiben. Nicht zuletzt bedarf es an Informatikern, um die neuen Technologien effizient nutzen zu können. Am Schluss ist aber die schönste Simulation nutzlos, wenn die Nutzerinnen und Nutzer sie nicht verstehen, oder nicht wissen, was sie damit anfangen sollen.

Handfester Nutzen für die Gesellschaft

Klimamodelle sind Instrumente für Forschende, mit denen sie Hypothesen testen, Prozesse verstehen lernen und Messdaten interpretieren. Aber nicht nur: Klimamodelle werden für Prognosen verwendet, um die Risiken und Verwundbarkeit der Gesellschaft und Infrastruktur zu minimieren und robuste Anpassungsmassnahmen zu finden. Der Dialog mit und der Nutzen für die Benutzerinnen und Benutzer ist dabei zentral: Erst wenn wir Klimamodellierer verstehen, welche Informationen für welchen Ort und Zeitraum der Landwirt oder die Bauingenieurin brauchen, können wir die Modelle für die Anpassung verbessern – ein Paradebeispiel, bei dem sich technische Entwicklung und inter- und transdisziplinäre Forschung ergänzen, um der Gesellschaft einen handfesten Nutzen zu bringen.

Öffentlicher Vortrag über Klimamodelle

Am Latsis Symposium 2019 der ETH Zürich diskutieren Wissenschaftlerinnen und Wissenschaftler über die nächste Generation von Klimamodellen, die die ganze Erde mit Gitterweiten von einem Kilometer simulieren und dabei die Grenzen der Informatik ausloten. Am Mittwoch 21.8. um 18:00 Uhr, beleuchtet Reto Knutti in einem Vortrag die Möglichkeiten und Herausforderungen des Klimawandels und wie uns neue Modelle helfen, die Risiken zu minimieren. Der Vortrag ist öffentlich und richtet sich auch an interessierte Laien. Der Eintritt ist frei, die Vortragssprache ist englisch. Weitere Informationen: https://latsis2019.ethz.ch/

Referenz

1 externe Seite How well have climate models projected global warming? Zeke Hausfather, Carbonbrief, 5.10.2017

2 Fischer EM, Knutti R. Observed heavy precipitation increase confirms theory and early models. Nature Climate Change volume 6, pages 986–991 (2016). doi: externe Seite 10.1038/nclimate3110

Kommentare

Zu wissen wie häufig und intensiv künftige Hochwasser sind, wie lange Dürrephasen oder Hitzewellen dauern ist äusserst hilfreich für Länder und Regionen, die ihre Infrastrutkur rechtzeitig und in genügendem Umfang anpassen wollen. Für viele Küstenstädte ist auch der zu erwartende Meeresspiegelanstieg wichtig. Soll etwa Lower Manhattan den geplanten Seewall noch vor dem Jahr 2050 bauen oder kann es noch länger warten? Die Herausforderung an Klimamodelle sehe ich in der Verifizierung. Die Software von heute welche das Klima in 30 Jahren voraussagt, kann auch erst in 30 Jahren verifiziert werden. Oder gibt es doch bessere Verifikationsmethoden?

Ich bin zwar ein Laie, aber Sie können das Modell zum Beispiel mit den meteorologischen Daten von 1989 füttern und beobachten, wie sehr die Simulation von den gemessenen Daten in der Spanne 1989-2019 abweicht. Ich vermute, die grösste Schwierigkeit liegt darin, dass wir - je weiter wir in die Vergangenheit gehen - weniger Daten haben und dass diese auf eine Art und Weise gespeichert sind, welche die Übersetzung in einen für moderne Software lesbaren Datensatz zu einem Albtraum macht. Aber grundsätzlich ist das möglich (und es gibt eine Vielzahl von mathematischen Methoden, die entwickelt wurden, sodass man mit lückenhaften Datensätzen dennoch sinnvoll arbeiten kann).

Herr Knutti, Sie schreiben: “Klimamodelle sind Instrumente für Forschende, mit denen sie Hypothesen testen, Prozesse verstehen lernen und Messdaten interpretieren.” Wirklich? Ich meinte, Hypothesen müssten mit der Realität (empirische Daten) verglichen werden, bevor man konkreteres wagt. Ein Model ist erst aussagekräftig wenn es validiert ist. Scheinbar ist’s in der Klimawissenschaft aber nicht so. Oder täusche ich mich?

Kann man überhaupt je voraussagen, "ob es im bündnerischen Sedrun im Jahr 2040 noch genügend Schnee hat"? Ich meine, es gibt ja noch so etwas wie "sensitive Abhängigkeit von den Anfangsbedingungen", besser bekannt als Chaostheorie oder Schmetterlingseffekt, und ein hoch aufgelöstes Chaos ist doch immer noch ein Chaos, um es salopp auszudrücken?